Was du lernen wirst

- Was Deepfakes sind

- Wie Deepfakes erkannt werden

- Was man tun sollte, wenn man Opfer von Deepfakes wird

- Welche Maßnahmen und Tools womöglich gegen Deepfakes helfen werden

Deepfakes: KI-Bilder erkennen und handeln. Wir stellen uns den Fragen:

„Wie erkenne ich Deepfakes?“

„Gibt es Tools zum Erkennen von KI-Bilder?“

„Jemand verbreitet Deepfake Bilder oder Videos über mich, was soll ich tun?“

Glossar

Ein Glossar mit wichtigen Begriffen, die im Inhalt stehen.

- Generative Künstliche Intelligenz (KI): Eine Generative Künstliche Intelligenz (KI) ist ein AI-System (Artificial Intelligence), das selbstständig in der Lage ist, Inhalte wie Bilder, Videos, Texte oder Musik zu erstellen.

- Deepfakes: Deepfakes sind Videos, Bilder oder auch Sprachaufnahmen, deren Inhalt unwahr ist und sich niemals zugetragen hat.

Inhaltsverzeichnis

Deepfakes: KI-Bilder erkennen

Heute widmen wir uns der grauenhaften Vorstellung von Deepfakes: KI-Bilder erkennen und handeln.

Du erfährst:

- Was Deepfakes sind

- Welche Tools es für das Aufspüren von KI-Deepfakes gibt

- Wie du als Opfer von AI-Deepfakes handeln solltest

- Wie Cyberkriminelle die KI-Technik missbrauchen

Jetzt stell dir eine junge Frau namens Lisa vor.

Sie könne blonde, schulterlange Haare tragen. Sie sei schlank und habe ein spitzes Kinn, ausgeprägte Wangenknochen. Schneeweißes Gesicht, knallig-rote Lippen. Ihre grün-braunen Augen leuchten ähnlich verzaubernd wie das Lichtspiel des Sonnenscheins auf die Elboberfläche.

Sie verliert ihre Ausbildung. Sie geht nämlich nicht mehr hin.

Lisa ist erdacht, beruht jedoch auf den Geschichten vieler Frauen, genauso vieler Männer. Seien sie in der Öffentlichkeit aktiv, etwa als Influencer, Bürgerhelfer oder sie haben sich einfach von den falschen Leuten getrennt – es soll so makaber klingen. Aber genauso Erpresser versuchen, ihre Opfer mit Fakes gefügig zu machen.

Zum Ende dieses Artikels findest du Dokumentationen zum Thema. Dort geht es um einen ähnlichen Fall. Außerdem liest du folglich über Deepfakes und KI-Bilder erkennen und wie du handeln kannst.

Was Deepfakes sind und wie sie erstellt werden

Deepfakes sind gefälschte Medien.

Womöglich erinnerst du dich an einige aufsehenerregende Bilder, die zuletzt durch die Medien gingen.

Es sind Bilder wie diese:

- Der Papst im auffälligen Mantel, ähnlich, als sei er eine Figur aus einem Hip-Hop-Video.

- Bilder auf den Donald Trump verhaftet und abgeführt wird.

- Und viele weitere Bilder, die auf den ersten Blick wie aufwendig gestellte Aufnahmen wirken.

Auf den zweiten Blick offenbaren diese Bilder markante Bildfehler. Etwa die Hand des Polizisten. Oder das Ohr des Ex-US-Präsidenten.

Deepfakes und Künstliche Intelligenz: Eine Mischung die den feuchtesten Sehnsüchten von Propagondisten befriedigen muss.

Mussten solche Bilder früher aufwendig mittels Photoshop bearbeitet werden, braucht es heute bloß ein Profilbild des möglichen Opfers, etwas Gehirnschmalz, Programmiererfahrung und einen Open-Source KI-Bildgenerator wie Stable Diffusion, um einen Deepfake zu generieren.

Die zwei obigen Bilder stammen aus dem Bildgeneratoren Midjourney. Mittlerweile hat der Anbieter hinter Midjourney gehandelt und schränkte seinen Generative AI Image Generator ein. Kostenlose Nutzung entfiel und die Buchung eines Abos fordern den Nutzer auf, mehr seiner Daten preiszugeben.

Jedoch bieten sich neben kommerziellen Anbietern auch Open-Source-Generatoren an, etwa Stable Diffusion.

Gefahren lauern jedoch nicht bloß hinter brillant gefälschten Bildern. Auch Sprachdateien und Videos werden mithilfe von AI Generatoren spielend leicht gefälscht. Erinnerst du dich an die falschen Drake Lieder?

Noch kann man diese Fakes anhand Details erkennen, doch dies erfordert einen aufmerksamen Blick. Einen Blick, der in Zeiten der Beschleunigung durch Social Media immer mehr Personen abhandenkommt.

Wie wäre es mit Harry Potter oder Luke Skywalker als Models für Balanciaga?

Was hier sehr unterhaltend wirkt, zeigt gleichermaßen eindrucksvoll die Gefahren solcher Techniken. Es braucht bloß wenige Iterationen und diese Large-Language-Models erstellen Bewegbilder von bekannten Persönlichkeiten.

Selbst die Stimmen kommen sehr nah an ihre Originale. Und die Entwicklung jener KI-Werkzeuge schreitet immer weiter voran.

Beispielhaft seien die beeindruckendenen Videos durch den Text-zu-Video-Generator OpenAIs Sora-Sprachmodell zu nennen.

Wie Deepfakes und KI-Bilder erkannt werden

Du fragst dich schon:

- „Wie werden Deepfakes und KI-Bilder erkannt?“

- „Welche Details verraten, ob ein Bild ein Deepfake beziehungsweise KI-Bild ist?“

Details, die auf generative Bilder hinweisen

- Hände haben mehr oder weniger als fünf Finger

- Arme, Beine wirken unnatürlich langgezogen

- Augen sind erkennbar skurril

- Objekte sind verbogen oder weltfremd aneinandergereiht

- Bilder wirken zu hochpoliert, weichgezeichnet

Details, um Sprachfälschungen zu erkennen

- Stimme klingt wie aus einer Konzerthalle

- Monotone Stimmlage

- Aussprachefehler

- Seltsame Beigeräusche während Sprechen (vorbeifahrende Autos, …)

Details, die generative Videos entlarven

- Personen im Video blinzeln sehr selten oder zu häufig. Die Pupillen der Augen wirken entstellt.

- Nur Oberkörper sind zu sehen und die Mundbewegung wirken schlecht synchronisiert.

- Bildfehler, die wie Grafikfehler in Videospielen wirken (Graphic-Glitches).

Weitere Verhaltenstipps im Umgang mit Deepfakes

- Hinterfragen: Frage dich immer: „Kann das wirklich so passiert sein?“, und recherchiere auf unabhängigen Kanälen. Das heißt: Suche bei Nachrichtensendern wie ARD nach Meldungen zum Geschehen.

- Nutze Tools: Google bietet seit Jahren die Bilderrückwärtssuche oder auch Google Lens. Damit lassen sich Bilder hochladen und prüfen, ob es diese bereits einmal gab oder ob sie noch gar nicht im Suchalgorithmus vorkamen. Außerdem rollt Google derzeit eine About this Image-Funktion aus; dazu liest du unten mehr!

Wie Kriminelle Künstliche Intelligenz missbrauchen

Neben gefälschten Liedern von Drake und weiteren Musikern, werden AI Generatoren auch für weitere Straftaten missbraucht.

Beispielsweise seien Fake-Pornos von Influencern oder eines Mitmenschens. Hier handeln oftmals Einzeltäter. Was treiben wohl kriminelle Gruppierungen mit Deepfakes?

Erste kriminelle Gruppen sollen KI-Technologie für Soundmanipulation etwa für Enkeltrick-Telefonanrufen missbrauchen. Beim Enkeltrick werden Opfer mit Schockanrufen verunsichert. Angehörige seien in Not und bräuchten dringend Geld.

Wenn ein Bösewicht nun die Stimmen nachahmen kann, erreichen diese kriminellen Machenschaften neue Qualitäten. In der Tat ließen sich auch Telefonnummern auf den Displays eines Zieles manipulieren (ID Spoofing).

Aber wie lässt sich jetzt ein Deepfake im Detail erstellen?

Nehmen wir das Beispiel einer Tonaufnahme.

Hierzu bedarf es lediglich einer passenden KI, die Stimmen synthetisieren kann. Eine Google Suche hierzu spült zur Genüge Anbieter heran.

Zweitens braucht es eine Stimmaufnahme, die braucht nicht einmal lang auszufallen. Mitunter reicht eine Minute. Nichts ist einfacher als das. Wurdest du in letzter Zeit öfters von Unbekannten angerufen?

Selbstredend gibt es noch Probleme und Herasuforderungen. Etwa können die Stimmen etwaige Hintergurndgeräusche mit abspielen. Zum Beispiel folgen auf Buchstaben die Geräusch vorbeifahrender Polizeiautos, wenn die Tonaufnahme solche Töne enthält.

Dennoch: Deepfakes erstellen ist leichter als jemals zuvor und obendrein völlig kostengünstig.

Tools zum Deepfakes aufspüren und bekämpfen

Folgend findest du eine ständig aktualisierte Liste an Tools und Möglichkeiten, mit denen du Deepfakes: KI-Bilder erkennen kannst.

Die folgenden Tools eignen sich für:

- Deepfakes wie KI-Bilder erkennen

- Möglichkeiten zum Bilder signieren

- Gefälschte Sprachdateien erkennen

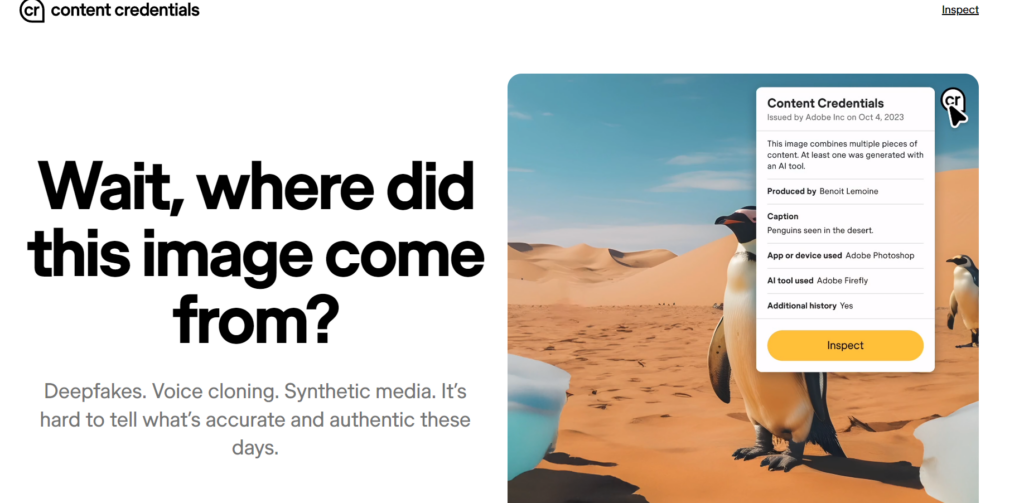

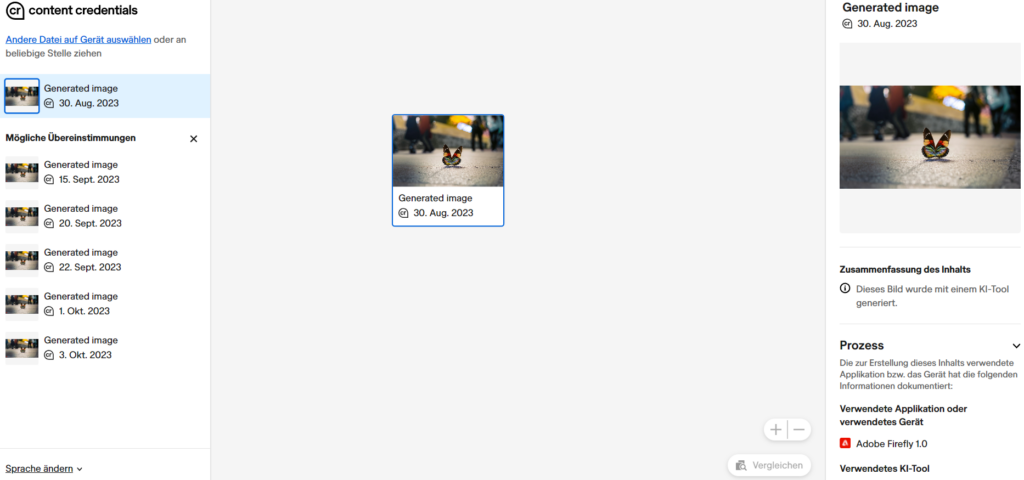

Content Credentials von Adobe

Contentcredentials.org soll ein neuer offener Standard in Zeiten von generativen KI-Bildgeneratoren werden. Content Credentials signiert Bilder, indem verschlüsselte sowie signierte Meta-Daten der Bilddatei hinzugefügt werden.

Anschließend sind die Meta-Daten auslesbar. Adobe, welches hinter der Software-Lösung steckt, bietet Plugins an, somit Bilder über all im Netz geprüft werden könnten.

Bei Content Credentials von Adobe handelt es sich um eine junge Technologie. Die CR-Prüftechnik steht jedoch allen Herstellern offen, so bieten erste Kamerasysteme wie die Leica M11 eine Unterstützung dieser Krypto-Bildsignierung.

Content Credentials möchte Antworten auf Fragen bieten, Fragen wie:

- Wie wurde dieses Bild erschaffen?

- Handelt es sich um ein KI-Bild?

- Von wann stammt dieses Bild?

- Welche Bearbeitungstools wurden verwendet?

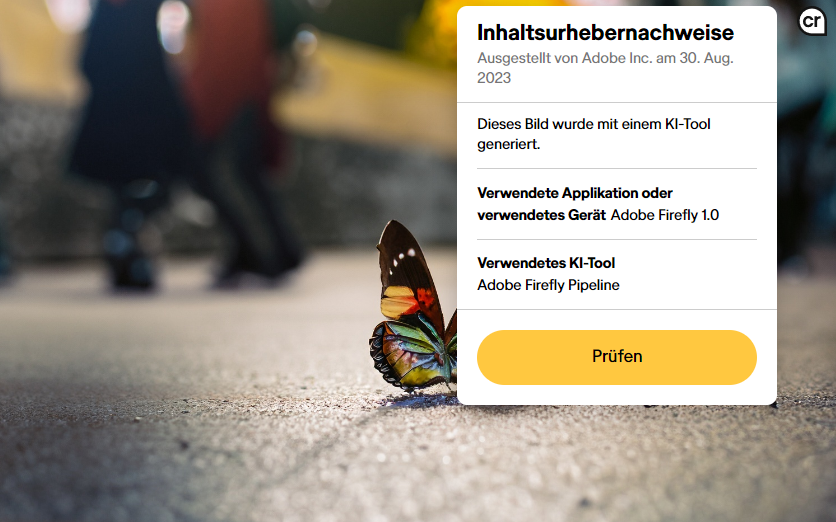

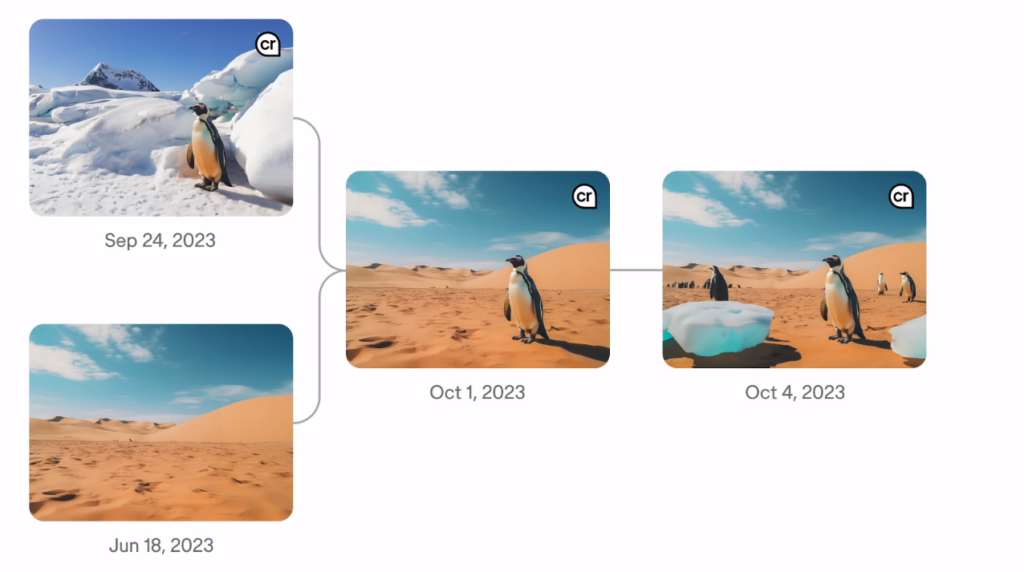

Weiterhin lassen sich bei, durch CR von Adobe nachweislich, berechneten Bildern eine Bearbeitungshistorie prüfen:

Informationen die wir aus einer übersichtlichen Web-Oberfläche erhalten:

Wie oben erwähnt, bietet Leica die CR-Signierung in seiner M11-Kamera an. Laut der Webseite ContentCredentials.org sollen unter weiteren, auch Microsoft oder Nikon am CR-Standard teilnehmen.

Eine Frage der Zeit und gallopierenden Nachfrage, wann CR-Signierung ihren Weg auf Smartphones finden wird. Oder ein ähnlicher zukünftiger Standard.

In Photoshop kann Content Credentials erprobt werden. Hierzu bedarf es jedoch eines Opt-Ins in das Beta-Programm.

Anschließend erhalten Bilderwerke Meta-Einträge wie:

- Autorennamen

- Schrittweise-Bearbeitungsverweise (dürfte Filter-Jonglierer nicht gefallen)

- Genutzte Software

- Signierung und Ausstellungshinweis

- Etwaig genutzte Elemente

Jedenfalls prescht die Frage empor: Wie sicher sind diese Art von signierten Meta-Daten nachher wirklich? Sind, besser gefragt: Werden diese Daten fälschungssicher bleiben?

Überzeugender, als offener Standard kaum zu tragen, wäre wohl eine Art Medien-Server, der prüfbar macht, ob eine Bildkopie mit einer Originaldatei Pixel für Pixel und jeweiligen Farbwert übereinstimmt. Womöglich bietet Adobe in Zukunft etwas ähnliches.

About this Image von Google

Google integriert in seine Bildersuche einen Faktencheck. Mit dem Check lassen sich Bilder prüfen, genauer:

- Wann ein bestimmtes Bild das erste Mal in der Google Bildersuche aufgetaucht ist

- Bilder werden dann mit genauen Erscheinungsdaten und Herkunft angezeigt.

Mehr hierzu in The Keyword Blog.

Weitere Optionen gegen Deepfakes

- Kryptographie: Dateien mit eindeutigen Schlüssel signieren. Bisher arbeiten Unternehmen wie Adobe an verschlüsselten Meta-Daten für Bilder. Diese Meta-Daten sollen beispielsweise erkennbar machen, ob ein Bild von einer KI oder aus einem Kamera-System stammt. Dazu liest du weiter oben: Content Credentials.

Was Opfer von Deepfakes tun sollten

Wenn du Opfer von Deepfakes oder gefälschten Media-Dateien wirst, solltest du dich dringend an die Polizei wenden.

Auch wenn du eine solche Tat als Außenstehender miterlebst, solltest du handeln und dem Opfer deine Hilfsbereitschaft signalisieren und die Person zur Polizei bringen.

Wichtig falls möglich:

- Dateien sicherstellen

- Links sicherstellen

Beweismittel sollten jedoch nur gespeichert werden, wenn es dir vom Gesetz her möglich ist! Begehe keine Straftat, indem du sensible Daten auf deinen Speichermedien speicherst!

Aber in jedem Fall solltest du die Polizei aufsuchen oder dich einer Vertrauensperson anvertrauen.

Dokus und Videos über Deepfakes

Folglich Videos, Reportagen, Dokumentationen über Deepfakes.

Terra X Doku

MDR: Deepfake Reportage

Fazit

Was erwartet uns in der Zukunft?

Bisher war es mehr als offensichtlich: Wir Menschen glauben zu gerne Dingen vorschnell, wenn diese unserer Meinungen und Ansichten entsprechen. Oder Dingen, denen wir erst skeptisch gegenüberstehen, von denen wir wiederholt und wiederholt hören und ihnen doch eines Tages etwas abgewinnen. Oder plötzlich mindestens Teile davon glauben.

Schon die Rockband Die Ärzte besungen dieses Thema 2008 mit dem Liede: Lasse reden.

Viele Menschen glauben zu gerne die verrücktesten Dinge. Dinge, die nicht unwahrer sein können. Gerade wenn es Menschen trifft, die wir sowieso nicht leiden können. Eine Tatsache, die in den nächsten Jahren noch die ein oder anderen Absurditäten zutage fördern wird.

Momentan toben sich einzelne Individuen mit dieser Technik aus. Was passiert, wenn es gänzliche Gruppen werden?

Werden wir in einer Welt leben, in der die Mehrheit alles als unwahr ansehen wird? Aktuell glaubt die Mehrheit das meiste, was sie sieht. Man muss es nur gut verpacken. Emotional. Und es wiederholen sowie widerholen; ganz wie Gustave Le Bon es in Psychologie der Massen beschrieb.

Weiterlesen

Weitere Informationen und Quellen

- BSI – Bund; Beispiele für Deepfakes mit Video(!): https://www.bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Informationen-und-Empfehlungen/Kuenstliche-Intelligenz/Deepfakes/deepfakes_node.html#doc1009562bodyText5

- Stern.de; wie man KI-Bilder erkennt: https://www.stern.de/digital/kuenstliche-intelligenz–auf-diese-weise-erkennen-sie-ki-bilder-33439360.html

Häufige Fragen und Antworten

Was sind Deepfakes?

Deepfakes sind:

- Bilder, Sounddateien oder Videos, die nicht der Wahrheit entsprechen und oftmals das Ziel verfolgen bestimmte Personen anzugreifen.

- Deepfakes sollen Personen oftmals durch Nennung falscher Tatsachen in Bedrängnis bringen.

- Deepfakes dienen also dem gezielten Mobbing, Bloßstellen.

Wie funktionieren Deepfakes?

Deepfakes werden mithilfe von künstlicher Intelligenz (KI) erstellt. Die KI wird mit einem großen Datensatz von Bildern und Videos einer Person trainiert, um die Merkmale ihres Gesichts und ihrer Stimme zu lernen. Anschließend kann die KI verwendet werden, um ein neues Video oder Audio zu erstellen, in dem die Person so aussieht und klingt, als würde sie etwas sagen oder tun, was sie in Wirklichkeit nicht gesagt oder getan hat.

Wie wehre ich mich gegen Deepfakes?

Es gibt kein direktes Mittel gegen Deepfakes. Die beste Abwehrstrategie besteht darin, den Täter bei Ermittlungsbehörden anzuzeigen. Notwendigerweise ist bei unbekannten eine Anzeige gegen Unbekannt.

Wie erfahre ich, ob ich Opfer von Deepfakes geworden bin?

Oft ist es gar nicht so einfach, herauszufinden, ob man Opfer von Deepfakes geworden ist.

Aber es lohnen sich folgende Strategien:

- Den eigenen Namen gelegentlich in Suchmaschinen suchen.

Wie kann man Deepfakes erkennen?

Es ist nicht immer einfach, Deepfakes zu erkennen, aber es gibt einige Anzeichen, auf die man achten kann:

- Unstimmigkeiten: Achte auf Unstimmigkeiten in der Beleuchtung, den Schatten oder der Perspektive.

- Verpixelung: Deepfakes können manchmal verpixelt oder verschwommen sein.

- Unnatürliche Bewegungen: Die Bewegungen der Person im Video können unnatürlich oder ruckartig sein.

- Fehlende Emotionen: Die Person im Video kann emotionslos oder starr wirken.

Was sind die Risiken von Deepfakes?

Deepfakes können für verschiedene Zwecke missbraucht werden, z. B.:

- Verbreitung von Fehlinformationen: Deepfakes können verwendet werden, um Fehlinformationen zu verbreiten oder die öffentliche Meinung zu manipulieren.

- Schädigung des Rufs: Deepfakes können verwendet werden, um den Ruf einer Person zu schädigen oder sie zu belästigen.

- Identitätsdiebstahl: Deepfakes können verwendet werden, um die Identität einer Person zu stehlen und sich als sie auszugeben.